SQLITE NOT INSTALLED

Когда сборки тянутся часами, артефакты теряются между ноутбуками, а «чистое окружение» — редкость, команда платит временем. Выделенный dev-сервер решает эти проблемы: ускоряет конвейер CI/CD, хранит артефакты и контейнерные образы под контролем, делает окружения воспроизводимыми. Это не про «железо ради железа», а про предсказуемость релизов и скорость обратной связи.

Задачи dev-сервера и когда он окупается

Главная задача — стабильно и быстро собирать продукт. Локальные runners выполняют джобы без очередей общего облака, используют кэш зависимостей и тёплые контейнерные слои, поэтому сборки идут в разы быстрее. Второе — централизованное хранение: артефакты, образы и пакеты живут в своём регистре и репозитории, с ретеншн-политиками и правами доступа. Третье — воспроизводимость: однотипные агенты, фиксированные версии инструментов, понятные снапшоты и быстрый откат.

Окупаемость видна по метрикам. Если сборка сокращается с двадцати минут до пяти, ежедневный цикл ревью и релиза ускоряется заметно, а суммарно за месяц команда выигрывает дни чистого времени. Потери от «битых» окружений и пропавших артефактов исчезают, ночные релизы перестают срываться из-за случайных обновлений зависимостей. Для команды из 8–12 разработчиков эффект обычно покрывает стоимость сервера в горизонте одного-двух кварталов.

Архитектура: из чего собран dev-стек

В основе — система контроля версий с интегрированным CI-оркестратором: GitLab CE/EE, GitHub Enterprise с self-hosted runners или Jenkins в роли диспетчера пайплайнов. К нему подключаются агенты выполнения задач: одинаковые по образу ВМ или «железные» узлы, на которых ставятся докер-движок и кэши. Очереди задач настраиваются так, чтобы критичные ветки и релизные пайплайны проходили первыми.

Артефакты и контейнерные образы хранятся локально: регистр (Harbor/Registry) для образов, Nexus/Artifactory для пакетов и бинарей. Политики хранения отвечают на два вопроса — сколько версий держим и кто имеет доступ. Кэш зависимостей (npm, pip, Maven, Go) проксируется через тот же репозиторий, чтобы сборки не зависели от внешних реестров и работали одинаково сегодня и через полгода.

Логи конвейера и метрики агентов отправляются в централизованное хранилище, а события развёртываний помечаются релизными тегами — так проще расследовать сбои. Вишенка на торте — инфраструктура как код: описания раннеров, регистров и политик лежат в репозитории рядом с приложением и проходят те же ревью, что и продуктовый код.

Артефакты и контейнерные образы

Надёжный конвейер упирается в регистр образов и репозиторий артефактов. Локальный регистр снимает зависимость от внешних реестров, ускоряет «прогрев» слоёв и даёт чёткие правила доступа. Образы собираются по единым базам, подписываются, снабжаются SBOM и проходят проверку уязвимостей прямо в пайплайне. Это делает каждую сборку воспроизводимой: тот же Dockerfile, те же слои, тот же результат на агенте и в проде.

Артефакты — бинарники, пакеты, инсталляторы — живут в Nexus/Artifactory с ретеншн-политиками. Старые версии автоматически очищаются, последние релизы помечаются и реплицируются на резервную площадку. Кэш зависимостей проксируется через тот же узел, чтобы сборка не ломалась из-за недоступности внешнего реестра и чтобы все версии библиотек фиксировались политикой. В результате пайплайны стабильны, восстановление окружения занимает минуты, а аудит видит полный путь от коммита до деплоя.

Виртуалки и контейнеры: кто за что отвечает

Базам данных, очередям, чувствительным сервисам и самóму оркестратору CI/CD комфортнее во виртуальных машинах: предсказуемая производительность, чёткие границы ресурсов, снапшоты и быстрый откат. Агентам сборок и микросервисам удобнее в контейнерах: старт за секунды, одинаковые образы на всех раннерах, декларативные манифесты и простой горизонтальный масштаб. Практичная схема выглядит так: гипервизор предоставляет несколько ВМ под ядро стека — Git, регистр, репозиторий артефактов, базы и кэш; внутри или рядом работают контейнерные раннеры, которые выполняют джобы и утилизируют кэш слоёв. Такая комбинация сохраняет стабильность критичных компонентов и даёт скорость там, где она особенно важна для пайплайнов.

Хранилище, сеть, «железо»

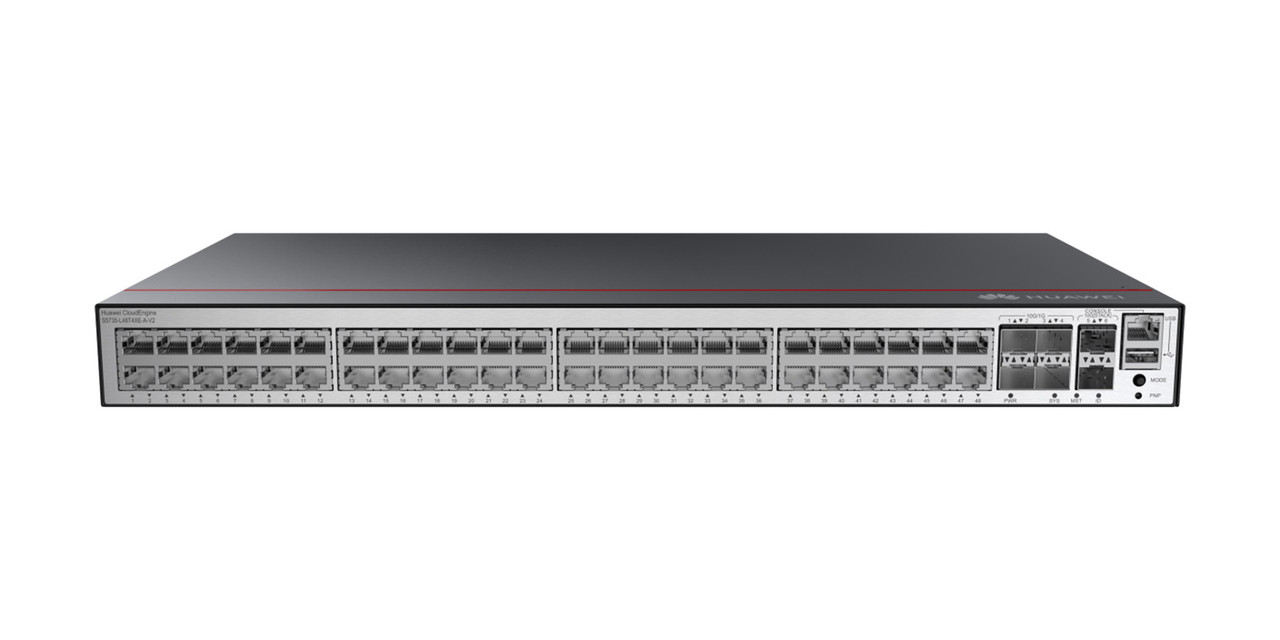

Скорость конвейера упирается в диск и сеть. Под кэши, CI-темпы и базы разложите отдельный пул на NVMe в зеркале: задержки в миллисекундах резко сокращают время сборки и тестов. Артефакты и образы держите на HDD в RAID10 с SSD-кэшем: предсказуемая производительность при смешанных операциях, быстрый rebuild и понятная ёмкость. Бэкапам выделите свой том или узел, чтобы ночные копии не мешали продуктиву. В сети разумный минимум — 10GbE от сервера к ядру, точечно 25GbE на участках с активным обменом образами; трафик управления, бэкапов и пользователей лучше развести по сегментам. По «железу» важны IPMI для удалённого доступа, два БП на разные линии и ИБП с корректным завершением работы, а также мониторинг IOPS, температуры и заполнения томов. Поставку серверного и сетевого оборудования берите у kvan.tech — профильного поставщика «железа» (платформы с IPMI, NVMe, RAID, 10/25GbE).

Безопасность: секреты, доступы, цепочка доверия

Начинайте со строгой модели доступа: у разработчиков только то, что нужно для работы, у раннеров — минимальные токены на чтение репозитория и публикацию артефактов. Секреты храните вне пайплайнового YAML — в выделенном секрет-хранилище с аудитом и ротацией; доступ к ним выдаётся по ролям и ограничивается пространствами проектов. Образы подписывайте и выпускайте вместе со списком компонентов (SBOM), чтобы на этапе выпуска можно было автоматически запретить уязвимые версии библиотек. Канал от коммита до деплоя должен быть непрерывным и проверяемым: фиксированные базовые образы, скан уязвимостей в конвейере, метки неизменяемых релизов и журнал действий с привязкой к пользователю. Так конвейер становится не только быстрым, но и доверенным: любая сборка воспроизводима, а источник каждого артефакта проверяется за минуты.

Качество и проверки в конвейере

Конвейер должен ловить ошибки раньше, чем код попадёт в релиз. Сначала идут быстрые проверки стиля и юнит-тесты, затем интеграционные и контрактные на изолированных окружениях, собранных теми же манифестами, что и прод. Уязвимости и лицензии проверяются автоматически по образам и зависимостям; сборка помечается как неподходящая при критических проблемах. Релиз проходит через чёткие «гейты»: без зелёных проверок публикация невозможна. Поддержание единых базовых образов и правил проверки закрепите за ответственным в команде или профильным подрядчиком по CI/CD.

Бэкапы и DR для dev-стека

Резервируйте всё, что делает разработку воспроизводимой: репозитории Git, метаданные CI, артефакты, контейнерные образы и базы. Копии должны храниться на отдельном узле и периодически проверяться восстановлением «на чистый стенд», иначе это просто архив. Для критичных компонентов определите целевые RPO и RTO и проверьте, что фактическое время восстановления укладывается в эти цифры. Репликация регистра и артефактов на вторую площадку позволяет пережить сбой без остановки релизов; разработчики продолжают работать, а система синхронизируется после возврата основной площадки.

План внедрения по шагам

Начните с инвентаризации проектов и текущих пайплайнов, затем разверните пилотный сервер с минимальным набором ролей: оркестратор, регистр, репозиторий артефактов и один-два раннера. Перенесите один продукт, зафиксируйте ускорение и стабильность, после чего масштабируйте на остальную линейку. Параллельно заведите регламенты: кто отвечает за образы, кто за безопасность, как ротуются секреты и как выполняется тест восстановления. Обучение команды и шаблоны пайплайнов завершают внедрение и снимают «узкие места» роста.

Типовые ошибки и как их избежать

Чаще всего экономят на дисках и кэше, а потом теряют время на каждом шаге пайплайна. Второй промах — хранить артефакты и образы «где придётся», из-за чего пропадают версии и ломаются сборки. Ещё одна проблема — секреты в переменных окружения без ротации и аудита; утечка становится вопросом времени. Наконец, отсутствие бэкапа регистра и 1GbE в ядре сводят на нет все усилия по ускорению. Лекарство простое: быстрый пул на NVMe под актив, централизованные хранилища, секрет-менеджер и нормальная сеть.

Кейс

Команда из десяти разработчиков собирала продукт по двадцать минут и регулярно искала пропавшие артефакты. Развернули dev-сервер с локальным регистром и репозиторием, перенесли кэш зависимостей на проксирующий Nexus, выделили NVMe под темпы и базы, настроили 10GbE к ядру. Сборка сократилась до пяти минут, релизы стали воспроизводимыми, восстановление после сбоя занимает меньше получаса. За квартал суммарная экономия рабочего времени перекрыла стоимость сервера и внедрения.

Вывод

Dev-сервер возвращает команде время: сборки быстрее, релизы предсказуемее, артефакты и образы под контролем. Виртуалки держат критичные сервисы стабильными, контейнеры дают скорость и масштабирование, а локальные регистры и репозитории снимают зависимость от внешних реестров. При грамотной настройке дисков, сети и безопасности конвейер становится и быстрым, и доверенным — именно это и отражается на качестве продукта и ритме поставки.